WAVE SUMMIT 2023 圆满收官,邀您共享 NVIDIA 精彩时刻,感受全球顶尖技术盛宴!

NVIDIA 开发与技术部门亚太区总经理李曦鹏通过视频对本届大会送上了诚挚的寄语。他表示,此前 NVIDIA 发布了 NGC PaddlePaddle Container,为开发者提供了开箱即用的最新、最好的开发环境。目前,Paddle 的 FP8 和 Transformer Engine 的开发适配工作已经完成,并在中小模型上进行了验证。NVIDIA 很荣幸能与百度飞桨、文心大模型携手一道,共同成长,见证深度学习及大模型的飞速发展。

思想火花碰撞

大会期间,李曦鹏还受邀参加“携手飞桨 创新加速”分论坛高端对话,在 NVIDIA 与百度飞桨携手紧密合作 6 余年之际,与大家分享大语言模型面临的挑战、解决之道与未来展望。

圆桌论坛主持人:NVIDIA 亚太区资深产品负责人郑彬

>>以下以 Q&A 形式呈现精彩发言亮点<<

Q:

大语言模型的挑战是什么?

首先是训练规模与诸如深度学习时期大不相同,LLM 更为看重有效训练时长以及训练吞吐。其次是随着超大模型时代的到来,推理的调度和硬件配置变得非常复杂。这些对应到训练成本、推理成本和推理体验,都是很大的挑战。

Q:

大模型精细化面临着很多问题和挑战,过去做了些什么?现在正在做什么?

面对这些挑战,要从硬件、软件以及应用的各个层面去解决。在硬件层面,可能需要更大的集群,硬件需要一些创新,调度性可能和以往不太一样,甚至是存储、配套的系统也会有一些区别,要针对大模型进行优化,因为大模型至关重要,其消耗的资源也非同一般。在推理层面,除了软件做的更好,另一个很重要的是需要算法和硬件的结合创新。

Q:

对于未来的洞察,如何看待方向以及应用?

首先模型效果要提升,而成本则要降低下来,便于大规模适用。同时如果插件库全部都可以自选,存在不同的插件库,那么未来的可能性就更大。另外很重要的一点,即大语言模型的成本,不管是训练还是使用都要长期保持可控。

技术成果分享

在随后的分论坛上,来自 NVIDIA GPU 计算专家团队的王诗杰以及 NVIDIA 资深解决方案架构师郝尚荣,分别带来了“基于 NVIDIA GPU 的飞桨训练与推理优化”和“TensorRT-LLM 极致优化大语言模型的推理”主题分享,为大家介绍 NVIDIA 针对大语言模型最新的训练、推理优化解决方案实践。

“携手飞桨 创新加速”分论坛主持人:

NVIDIA 深度学习解决方案架构师翟健

动手体验课程

除了高端对话和前沿技术分享,NVIDIA 还在本届大会中带来了“使用 NeMo+ERNIE 搭建基于 LLM 的有声对话引擎”Workshop 课程,为大家讲解如何使用 NVIDIA NeMo Toolkit、NVIDIA Jetson 等工具助力开发。

NVIDIA 企业开发者社区经理李奕澎详细讲解了什么是 NVIDIA NeMo、使用 NeMo 训练 ASR 语音识别模型的方法、使用 NeMo 训练 TTS 语音合成模型的方法、使用 ERNIE Bot 文心一言进行对话交互的方法,以及如何在 Jetson 边缘计算设备上搭建有声对话引擎。干货内容满满,为到场听众带来无限启发。

总结

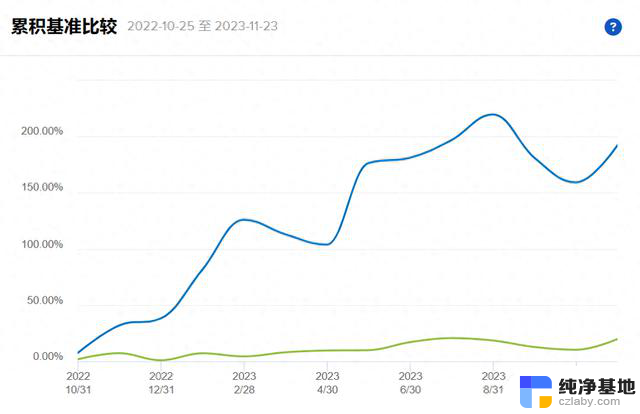

2023 年是大模型开启爆发式增长模式的一年,在这一年里,我们看到诸多企业构建了自己的基础大模型,也有幸见证了众多基于大模型而产生的上层应用,便利着人们的工作、学习和生活,开启了一个崭新的 AI 时代。如何在此基础上应对未来规模化和精细化的挑战,可能是摆在从业者面前的下一个命题。

本届 WAVE SUMMIT+ 深度学习开发者大会圆满落幕,NVIDIA 将藉由与企业、开发者们交流的宝贵经验,不断深耕、持续创新,继续为各行业提供先进的大模型解决方案,共享 AI 新未来!

*本文中图片来源于 WAVE SUMMIT+,若您有任何疑问或需要使用本文中图片,请联系 WAVE SUMMIT+。